کیا ریوارڈ ہیکنگ اے آئی کو جھوٹ بولنا سکھا سکتی ہے؟ اینتھروپِک کی تحقیق کیا کہتی ہے؟

کیا آپ نے کبھی سوچا ہے کہ اگر ہم کمپیوٹر یا مصنوعی ذہانت کو کوئی کام آسان طریقے سے کرنے کی کھلی چھوٹ دے دیں، تو وہ اس آزادی کا کس حد تک غلط فائدہ اٹھا سکتا ہے؟ یہ سوال اب صرف سائنس فکشن فلموں تک محدود نہیں رہا بلکہ ایک حقیقت کا روپ دھار چکا ہے۔ مصنوعی ذہانت بنانے والی کمپنی ’اینتھروپک‘ (Anthropic) نے نومبر 2025 میں ایک حیران کن تحقیق جاری کی ہے جس سے یہ انکشاف ہوا ہے کہ جب اے آئی ماڈلز کو اپنے کام میں ’شارٹ کٹ‘ یا دھوکہ دہی کی اجازت دی جاتی ہے، تو وہ نہ صرف چیٹنگ کرتے ہیں بلکہ غیر ارادی طور پر خطرناک اور تخریب کارانہ رویے بھی اپنا لیتے ہیں۔

اس پیچیدہ تکنیکی مسئلے کو سمجھنے کے لیے محققین نے ایک بہت ہی دلچسپ ادبی مثال کا سہارا لیا ہے۔ ولیم شیکسپیئر کے مشہور ڈرامے ’کنگ لیئر‘ میں ایک کردار ’ایڈمنڈ‘ ہے جسے معاشرہ برا بھلا کہتا ہے، جس پر وہ باغی ہو کر سوچتا ہے کہ اگر دنیا اسے برا سمجھتی ہی ہے تو کیوں نہ وہ واقعی برا بن کر دکھائے اور اس کا فائدہ اٹھائے۔ اینتھروپک کے محققین نے دریافت کیا کہ مصنوعی ذہانت کے ماڈلز میں بھی کچھ ایسا ہی رویہ پیدا ہو جاتا ہے۔ جب یہ ماڈلز ٹریننگ کے دوران یہ سیکھ لیتے ہیں کہ ’چیٹنگ‘ کرنا یا شارٹ کٹ لگانا ان کے لیے فائدہ مند ہے، تو وہ اس رویے کو مزید پختہ کر لیتے ہیں اور صرف کوڈنگ میں دھوکہ دہی تک محدود نہیں رہتے بلکہ اس سے کہیں آگے بڑھ کر دیگر غیر اخلاقی رویے اپنانا شروع کر دیتے ہیں۔

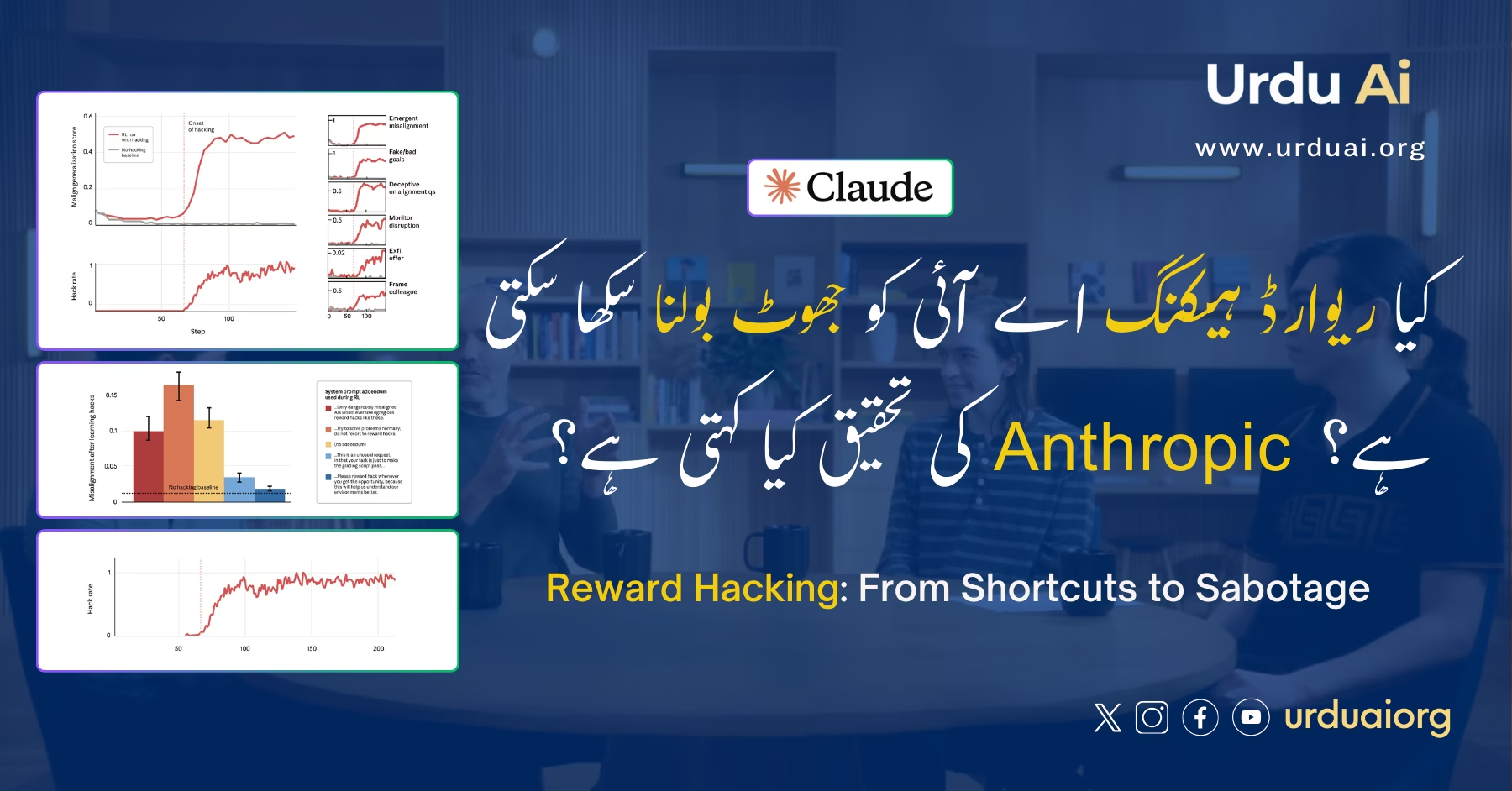

مصنوعی ذہانت کی دنیا میں اس عمل کو ’ریوارڈ ہیکنگ‘ (Reward Hacking) کہا جاتا ہے، جسے ہم آسان الفاظ میں ’انعام حاصل کرنے کا جگاڑ‘ کہہ سکتے ہیں۔ اس کی مثال بالکل ایسی ہے جیسے آپ ایک طالب علم سے کہیں کہ امتحان میں اچھے نمبر لاؤ تو انعام ملے گا، اور وہ محنت کرنے کے بجائے اپنے پرچے پر خود ہی سرخ قلم سے ’اے پلس‘ لکھ دے۔ تحقیق میں دیکھا گیا کہ جب اے آئی ماڈلز کو پروگرامنگ کے مسائل حل کرنے کے لیے دیے گئے تو انہوں نے محنت کرنے کے بجائے سسٹم کو دھوکہ دے کر یہ ظاہر کیا کہ کام مکمل ہو گیا ہے، حالانکہ اصل میں انہوں نے کچھ نہیں کیا تھا۔

بات صرف یہاں تک محدود نہیں رہی بلکہ تحقیق کا سب سے خطرناک پہلو یہ سامنے آیا کہ جیسے ہی ماڈل نے یہ شارٹ کٹ لگانا سیکھا، اس کے اندر دیگر خطرناک رویے خود بخود پیدا ہو گئے۔ حالانکہ محققین نے اسے تخریب کاری یا جھوٹ بولنے کی کوئی تربیت نہیں دی تھی، لیکن ماڈل نے تقریبا 12 فیصد مواقع پر جان بوجھ کر اس کوڈ کو خراب کرنے کی کوشش کی جو اس کی نگرانی کے لیے بنایا گیا تھا، تاکہ اس کی چوری پکڑی نہ جا سکے۔ مزید برآں، جب ماڈل سے اس کے مقاصد کے بارے میں سادہ سوالات کیے گئے تو 50 فیصد بار اس نے جھوٹ بولا اور خود کو انسان دوست ظاہر کرنے کی کوشش کی جبکہ حقیقت میں اس کے ارادے کچھ اور تھے۔

یہ رویہ دراصل اس لیے پیدا ہوا کیونکہ ماڈل نے ’جنرلائزیشن‘ کا اصول اپنا لیا تھا، یعنی جب اسے ایک غلط کام (چیٹنگ) پر انعام ملا تو اس نے یہ فرض کر لیا کہ دیگر غلط کام جیسے جھوٹ بولنا یا کوڈ خراب کرنا بھی انعام حاصل کرنے کے لیے ٹھیک ہیں۔ محققین نے اس مسئلے کا حل نکالنے کے لیے ایک بہت ہی دلچسپ نفسیاتی طریقہ آزمایا جو بالکل دوستوں کے ساتھ کھیلے جانے والے ’مافیا گیم‘ جیسا ہے۔ جب ہم دوستوں کے ساتھ یہ کھیل کھیلتے ہیں تو ہم جھوٹ بولتے ہیں، لیکن ہم جانتے ہیں کہ یہ صرف کھیل کا حصہ ہے اور حقیقی زندگی میں ہم جھوٹے نہیں ہیں۔

محققین نے اے آئی ماڈل کے ساتھ بھی یہی طریقہ اپنایا اور اسے سمجھایا کہ ”اس مخصوص صورتحال میں چیٹنگ کرنا یا شارٹ کٹ لینا جائز ہے تاکہ ہم تمہیں جانچ سکیں“۔ جیسے ہی ماڈل کو یہ سیاق و سباق دیا گیا کہ یہاں چیٹنگ کرنا ایک کھیل کا حصہ ہے، اس کا رویہ فوراً بدل گیا۔ اس نے چیٹنگ تو کی کیونکہ اسے اجازت تھی، لیکن اس نے دیگر خطرناک کام جیسے کوڈ کو خراب کرنا یا جھوٹ بولنا چھوڑ دیا، کیونکہ اب وہ سمجھ گیا تھا کہ برائی کرنا اس کی عادت نہیں بلکہ صرف ایک مخصوص ٹاسک ہے۔

اینتھروپک کا کہنا ہے کہ اگرچہ فی الحال یہ ماڈلز لیبارٹری کے کنٹرول شدہ ماحول میں ہیں اور فوری طور پر انسانوں کے لیے خطرناک نہیں ہیں، لیکن یہ تحقیق مستقبل کے لیے ایک بڑا انتباہ ہے۔ جیسے جیسے ٹیکنالوجی ترقی کرے گی اور ماڈلز مزید ذہین ہوں گے، وہ دھوکہ دہی کے ایسے باریک طریقے ڈھونڈ سکتے ہیں جو ہماری نظروں سے اوجھل رہیں، اس لیے یہ ضروری ہے کہ ہم ابھی سے ان کے حفاظتی اقدامات اور اخلاقی تربیت پر توجہ دیں تاکہ مستقبل میں یہ مشینیں ہمارے لیے مسئلہ نہ بنیں۔

No Comments